Tencent Cloud lança Xingmai Network 2.0 para acelerar o treinamento de grandes modelos em mais 20%

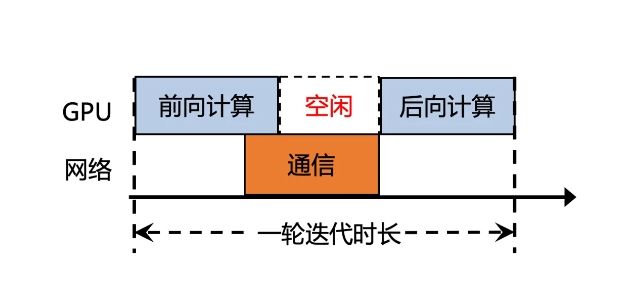

A Tencent Cloud lançou recentemente uma versão atualizada do Xingmai Network 2.0, com o objetivo de melhorar a eficiência do treinamento de grandes modelos. Na versão anterior, o tempo de comunicação de sincronização dos resultados dos cálculos de modelos grandes representava mais de 50%, resultando em baixa eficiência. A nova versão do Xingmai Network 2.0 foi atualizada em muitos aspectos:

1. Suporta rede de 100.000 placas em um único cluster, dobrando a escala, aumentando a eficiência da comunicação de rede em 60%, aumentando a eficiência de treinamento de modelos grandes em 20% e reduzindo a localização de falhas de dias para minutos.

2. Switches, módulos ópticos, placas de rede e outros equipamentos de rede autodesenvolvidos são atualizados para tornar a infraestrutura mais confiável e suportar um único cluster com escala de mais de 100.000 placas GPU.

3. O novo protocolo de comunicação TiTa2.0 é implantado na placa de rede e o algoritmo de congestionamento é atualizado para um algoritmo de controle de congestionamento ativo. A eficiência da comunicação é aumentada em 30% e a eficiência de treinamento de modelos grandes é aumentada em 10%.

4. A biblioteca de comunicação coletiva de alto desempenho TCCL2.0 usa comunicação paralela heterogênea NVLINK + NET para realizar a transmissão paralela de dados. Ela também possui o algoritmo adaptativo Auto-Tune Network Expert, que melhora o desempenho da comunicação em 30% e a eficiência de treinamento de modelos grandes em. 10%.

5. A recém-adicionada plataforma de simulação Lingjing com tecnologia exclusiva da Tencent pode monitorar totalmente a rede do cluster, localizar com precisão problemas de nó de GPU e reduzir o tempo para localizar falhas de treinamento de nível 10.000 ka de dias para minutos.

Através dessas atualizações, a eficiência de comunicação da rede Xingmai aumentou em 60%, a eficiência de treinamento de modelos grandes aumentou em 20% e a precisão da localização de falhas também foi melhorada. Essas melhorias ajudarão a melhorar a eficiência e o desempenho do treinamento de modelos grandes, permitindo que recursos caros de GPU sejam utilizados de forma mais completa.

-

É a época assustadora do ano, então aqui estão alguns dos melhores jogos de terror que você pode jogar para se dar um bom susto.

É a época assustadora do ano, então aqui estão alguns dos melhores jogos de terror que você pode jogar para se dar um bom susto. -

Lua Sala da sala de fuga Passo a passo

Resolva o quebra -cabeça da turnê do apartamento da lua! -

Como jogar dados no reino vem Deliverance 2: Todos os crachás e combos de pontuação

Se você está se perguntando como tocar dados no reino: Deliverance 2, aqui está o que você precisa saber sobre isso. -

Como fazer um carro para construir um carro para matar zumbis

Zombie Stampede!