Tencent Cloud が Xingmai Network 2.0 を発表し、大規模モデルのトレーニングをさらに 20% 高速化

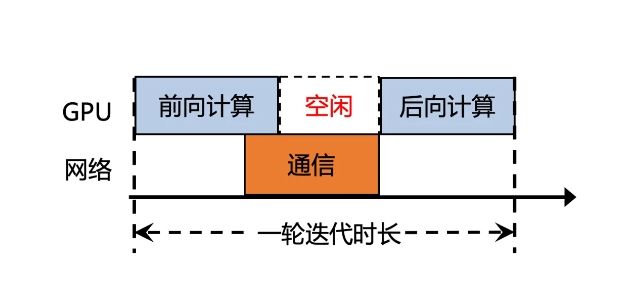

Tencent Cloud は最近、大規模モデルのトレーニング効率の向上を目的として、Xingmai Network 2.0 のアップグレード バージョンをリリースしました。従来バージョンでは、大規模なモデルの計算結果の同期通信時間が50%以上を占め、効率が低かった。 Xingmai Network 2.0 の新しいバージョンは、多くの点でアップグレードされています。

1. 単一クラスターで 100,000 枚のカード ネットワーキングをサポートし、規模を 2 倍にし、ネットワーク通信効率を 60% 向上させ、大規模モデルのトレーニング効率を 20% 向上させ、障害位置を数日から数分に短縮します。

2. 自社開発のスイッチ、光モジュール、ネットワーク カード、その他のネットワーク機器がアップグレードされ、インフラストラクチャの信頼性が向上し、100,000 GPU カードを超える規模の単一クラスターをサポートします。

3. 新しい通信プロトコル TiTa2.0 がネットワーク カードに導入され、輻輳アルゴリズムがアクティブ輻輳制御アルゴリズムにアップグレードされ、通信効率が 30% 向上し、大規模モデルのトレーニング効率が 10% 向上しました。

4. 高性能集合通信ライブラリ TCCL2.0 は、NVLINK+NET ヘテロジニアス並列通信を使用してデータの並列送信を実現します。また、Auto-Tune Network Expert 適応アルゴリズムを備えており、通信パフォーマンスが 30% 向上し、大規模モデルのトレーニング効率が向上します。 10%。

5. 新しく追加された Tencent 独自のテクノロジー Lingjing シミュレーション プラットフォームは、クラスター ネットワークを完全に監視し、GPU ノードの問題を正確に特定し、10,000 ka レベルのトレーニング障害を特定する時間を数日から数分に短縮します。

これらのアップグレードにより、Xingmai ネットワークの通信効率は 60% 向上し、大規模モデルのトレーニング効率は 20% 向上し、障害位置の精度も向上しました。これらの改善により、大規模モデルのトレーニングの効率とパフォーマンスが向上し、高価な GPU リソースをより最大限に活用できるようになります。

-

それは今年の不気味な時期ですので、ここにあなたが自分自身に良い恐怖を与えるためにプレイできる最高のホラーゲームのいくつかがあります。

それは今年の不気味な時期ですので、ここにあなたが自分自身に良い恐怖を与えるためにプレイできる最高のホラーゲームのいくつかがあります。 -

ムーンハウスルームエスケープウォークスルー

ムーンハウスアパートメントツアーパズルを解決してください! -

キングダムでサイコロのプレイ方法カム・デリバランス2:すべてのバッジとスコアリングコンボ

キングダムでサイコロをプレイする方法を疑問に思っているなら、来る:救出2、それについて知っておくべきことは次のとおりです。 -

ゾンビを殺すために車を作るために車を作る方法

ゾンビスタンピード!