Tencent Cloud, Xingmai Network 2.0 출시로 대규모 모델 훈련 속도 20% 더 향상

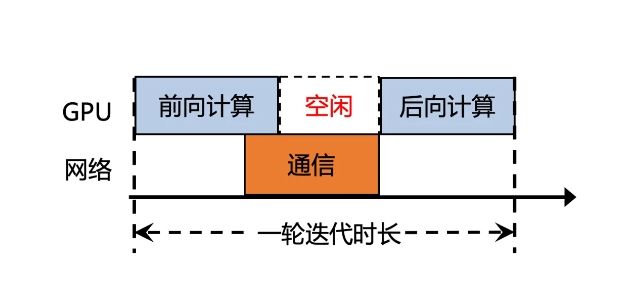

Tencent Cloud는 최근 대규모 모델 훈련의 효율성을 향상시키는 것을 목표로 Xingmai Network 2.0의 업그레이드 버전을 출시했습니다. 이전 버전에서는 대형 모델의 계산 결과 동기화 통신 시간이 50% 이상을 차지해 효율성이 낮았습니다. Xingmai Network 2.0의 새 버전은 여러 측면에서 업그레이드되었습니다.

1. 단일 클러스터에서 100,000개의 카드 네트워킹을 지원하여 규모를 두 배로 늘리고, 네트워크 통신 효율성을 60% 높이고, 대형 모델 교육 효율성을 20% 높이고, 오류 위치를 며칠에서 몇 분으로 줄입니다.

2. 자체 개발한 스위치, 광 모듈, 네트워크 카드 및 기타 네트워크 장비를 업그레이드하여 인프라의 안정성을 높이고 100,000개 이상의 GPU 카드 규모로 단일 클러스터를 지원합니다.

3. 네트워크 카드에 새로운 통신 프로토콜인 TiTa2.0을 적용하고 혼잡 알고리즘을 능동 혼잡 제어 알고리즘으로 업그레이드하여 통신 효율성을 30% 높이고 대형 모델 학습 효율성을 10% 높였습니다.

4. 고성능 집단 통신 라이브러리 TCCL2.0은 NVLINK+NET 이종 병렬 통신을 사용하여 데이터의 병렬 전송을 실현합니다. 또한 Auto-Tune Network Expert 적응형 알고리즘을 갖추고 있어 통신 성능을 30% 향상하고 대규모 모델 훈련 효율성을 향상시킵니다. 10%.

5. 새로 추가된 Tencent 독점 기술 Lingjing 시뮬레이션 플랫폼은 클러스터 네트워크를 완벽하게 모니터링하고 GPU 노드 문제를 정확하게 찾아내며 10,000ka 수준의 훈련 결함을 찾는 시간을 며칠에서 몇 분으로 단축할 수 있습니다.

이러한 업그레이드를 통해 Xingmai 네트워크의 통신 효율성은 60% 증가하고, 대형 모델 훈련 효율성은 20% 증가했으며, 결함 위치 정확도도 향상되었습니다. 이러한 개선 사항은 대규모 모델 훈련의 효율성과 성능을 향상시켜 값비싼 GPU 리소스를 더욱 완벽하게 활용할 수 있게 해줍니다.

-

올해의 으스스한 시간이므로 여기에 자신에게 좋은 공포를주기 위해 플레이 할 수있는 최고의 공포 게임이 있습니다.

올해의 으스스한 시간이므로 여기에 자신에게 좋은 공포를주기 위해 플레이 할 수있는 최고의 공포 게임이 있습니다. -

문 하우스 룸 탈출 연습

Moon House Apartment Tour Puzzle을 해결하십시오! -

왕국에서 주사위를 연주하는 법 2 : 모든 배지 및 득점 콤보

왕국에서 주사위를 연주하는 방법이 궁금하다면 : Deliverance 2, 여기에 대해 알아야 할 사항은 다음과 같습니다. -

좀비를 죽이기 위해 차를 짓는 차를 만드는 방법

좀비 스탬피드!