Tencent Cloud führt Xingmai Network 2.0 ein, um das Training großer Modelle um weitere 20 % zu beschleunigen

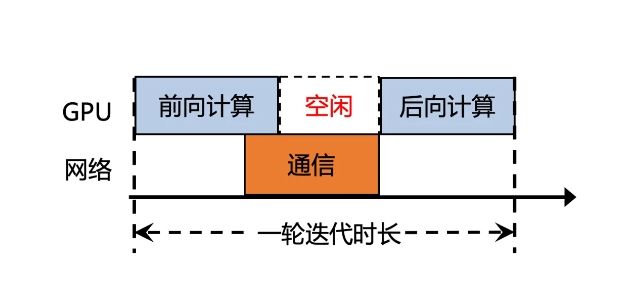

Tencent Cloud hat kürzlich eine aktualisierte Version von Xingmai Network 2.0 auf den Markt gebracht, mit dem Ziel, die Effizienz des Trainings großer Modelle zu verbessern. In der Vorgängerversion machte die Synchronisationskommunikationszeit der Berechnungsergebnisse großer Modelle mehr als 50 % aus, was zu einer geringen Effizienz führte. Die neue Version von Xingmai Network 2.0 wurde in vielerlei Hinsicht aktualisiert:

1. Unterstützt die Vernetzung von 100.000 Karten in einem einzigen Cluster, verdoppelt die Skalierung, erhöht die Effizienz der Netzwerkkommunikation um 60 %, steigert die Effizienz beim Training großer Modelle um 20 % und reduziert die Fehlerortung von Tagen auf Minuten.

2. Selbst entwickelte Switches, optische Module, Netzwerkkarten und andere Netzwerkgeräte werden aktualisiert, um die Infrastruktur zuverlässiger zu machen und einen einzelnen Cluster mit einer Größenordnung von mehr als 100.000 GPU-Karten zu unterstützen.

3. Das neue Kommunikationsprotokoll TiTa2.0 wird auf der Netzwerkkarte bereitgestellt und der Überlastungsalgorithmus wird zu einem aktiven Überlastungskontrollalgorithmus aktualisiert. Die Kommunikationseffizienz wird um 30 % und die Effizienz des Trainings großer Modelle um 10 % erhöht.

4. Die leistungsstarke kollektive Kommunikationsbibliothek TCCL2.0 nutzt die heterogene parallele Kommunikation von NVLINK+NET, um eine parallele Übertragung von Daten zu realisieren. Sie verfügt außerdem über den adaptiven Algorithmus Auto-Tune Network Expert, der die Kommunikationsleistung um 30 % und die Effizienz des großen Modelltrainings verbessert 10 %.

5. Die neu hinzugefügte Lingjing-Simulationsplattform mit exklusiver Tencent-Technologie kann das Clusternetzwerk vollständig überwachen, GPU-Knotenprobleme genau lokalisieren und die Zeit zum Auffinden von Trainingsfehlern auf 10.000-ka-Ebene von Tagen auf Minuten verkürzen.

Durch diese Upgrades wurde die Kommunikationseffizienz des Xingmai-Netzwerks um 60 % gesteigert, die Effizienz des Trainings großer Modelle um 20 % gesteigert und auch die Genauigkeit der Fehlerortung verbessert. Diese Verbesserungen werden dazu beitragen, die Effizienz und Leistung des Trainings großer Modelle zu verbessern, sodass teure GPU-Ressourcen besser genutzt werden können.

-

Es ist die gruselige Jahreszeit des Jahres. Hier sind einige der besten Horrorspiele, die Sie spielen können, um sich einen guten Angst zu machen.

Es ist die gruselige Jahreszeit des Jahres. Hier sind einige der besten Horrorspiele, die Sie spielen können, um sich einen guten Angst zu machen. -

Moon House Room Escape Wanderung

Lösen Sie das Mondhaus -Apartment -Tour -Puzzle! -

Wie man Würfel im Königreich spielt

Wenn Sie sich fragen, wie man in Kingdom Come Würfel spielt: Befreiung 2, dann müssen Sie darüber wissen. -

Wie man ein Auto im Bau eines Autos macht, um Zombies zu töten

Zombie Stampede!