Tencent Cloud meluncurkan Xingmai Network 2.0 untuk mempercepat pelatihan model besar sebesar 20% lagi

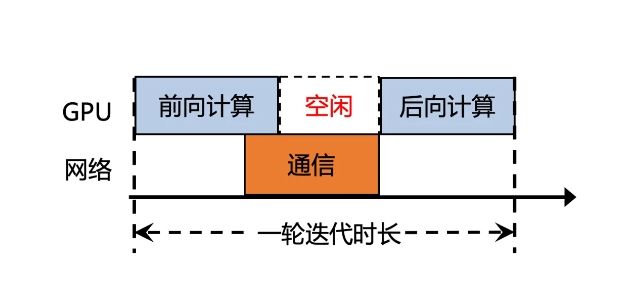

Tencent Cloud baru-baru ini meluncurkan versi terbaru dari Xingmai Network 2.0, yang bertujuan untuk meningkatkan efisiensi pelatihan model besar. Pada versi sebelumnya, waktu komunikasi sinkronisasi hasil perhitungan model besar menyumbang lebih dari 50%, sehingga menghasilkan efisiensi yang rendah. Versi baru Xingmai Network 2.0 telah ditingkatkan dalam banyak aspek:

1. Mendukung jaringan 100.000 kartu dalam satu cluster, menggandakan skala, meningkatkan efisiensi komunikasi jaringan sebesar 60%, meningkatkan efisiensi pelatihan model besar sebesar 20%, dan mengurangi lokasi kesalahan dari hitungan hari menjadi menit.

2. Sakelar, modul optik, kartu jaringan, dan peralatan jaringan lainnya yang dikembangkan sendiri ditingkatkan agar infrastruktur lebih andal dan mendukung satu cluster dengan skala lebih dari 100.000 kartu GPU.

3. Protokol komunikasi baru TiTa2.0 diterapkan pada kartu jaringan, dan algoritma kemacetan ditingkatkan menjadi algoritma kontrol kemacetan aktif meningkat sebesar 30%, dan efisiensi pelatihan model besar meningkat sebesar 10%.

4. Pustaka komunikasi kolektif berkinerja tinggi TCCL2.0 menggunakan komunikasi paralel heterogen NVLINK+NET untuk mewujudkan transmisi data paralel. Ia juga memiliki algoritma adaptif Auto-Tune Network Expert, yang meningkatkan kinerja komunikasi sebesar 30% dan efisiensi pelatihan model besar 10%.

5. Platform simulasi Lingjing teknologi eksklusif Tencent yang baru ditambahkan dapat sepenuhnya memantau jaringan cluster, menemukan masalah node GPU secara akurat, dan mengurangi waktu untuk menemukan kesalahan pelatihan tingkat 10.000 ka dari hitungan hari menjadi menit.

Melalui peningkatan ini, efisiensi komunikasi jaringan Xingmai telah meningkat sebesar 60%, efisiensi pelatihan model besar telah meningkat sebesar 20%, dan akurasi lokasi kesalahan juga telah ditingkatkan. Peningkatan ini akan membantu meningkatkan efisiensi dan kinerja pelatihan model besar, sehingga sumber daya GPU yang mahal dapat dimanfaatkan secara lebih maksimal.

-

Ini adalah waktu seram tahun ini, jadi inilah beberapa game horor terbaik yang bisa Anda mainkan untuk memberi diri Anda ketakutan yang bagus.

Ini adalah waktu seram tahun ini, jadi inilah beberapa game horor terbaik yang bisa Anda mainkan untuk memberi diri Anda ketakutan yang bagus. -

Moon House Room Escape Walkthrough

Selesaikan teka -teki tur apartemen Moon House! -

How To Play Dice in Kingdom Come Deliverance 2: Semua Lencana & Penilaian Combo

Jika Anda bertanya -tanya bagaimana cara bermain dadu di kerajaan datang: Deliverance 2, inilah yang perlu Anda ketahui tentang itu. -

Cara membuat mobil dalam membangun mobil untuk membunuh zombie

Zombie Stampede!