Tencent Cloud lanza Xingmai Network 2.0 para acelerar el entrenamiento de modelos grandes en otro 20%

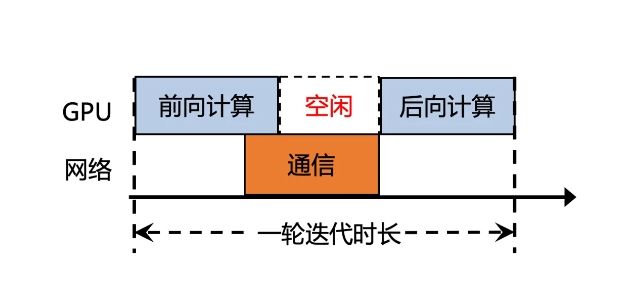

Tencent Cloud lanzó recientemente una versión mejorada de Xingmai Network 2.0, con el objetivo de mejorar la eficiencia del entrenamiento de modelos grandes. En la versión anterior, el tiempo de comunicación sincronizada de los resultados de cálculo de modelos grandes representaba más del 50%, lo que resultaba en una baja eficiencia. La nueva versión de Xingmai Network 2.0 se ha actualizado en muchos aspectos:

1. Admite redes de 100 000 tarjetas en un solo clúster, lo que duplica la escala, aumenta la eficiencia de la comunicación de la red en un 60 %, aumenta la eficiencia del entrenamiento de modelos grandes en un 20 % y reduce la localización de fallas de días a minutos.

2. Los conmutadores, módulos ópticos, tarjetas de red y otros equipos de red de desarrollo propio se actualizan para hacer que la infraestructura sea más confiable y admita un solo clúster con una escala de más de 100.000 tarjetas GPU.

3. Se implementa el nuevo protocolo de comunicación TiTa2.0 en la tarjeta de red y el algoritmo de congestión se actualiza a un algoritmo de control de congestión activo. La eficiencia de la comunicación aumenta en un 30% y la eficiencia del entrenamiento de modelos grandes aumenta en un 10%.

4. La biblioteca de comunicación colectiva de alto rendimiento TCCL2.0 utiliza comunicación paralela heterogénea NVLINK+NET para realizar la transmisión paralela de datos. También cuenta con el algoritmo adaptativo Auto-Tune Network Expert, que mejora el rendimiento de la comunicación en un 30% y la eficiencia del entrenamiento de modelos grandes en un 30%. 10%.

5. La plataforma de simulación Lingjing, con tecnología exclusiva de Tencent, recientemente agregada, puede monitorear completamente la red del clúster, localizar con precisión los problemas de los nodos de GPU y reducir el tiempo para localizar fallas de entrenamiento de nivel 10,000 ka de días a minutos.

A través de estas actualizaciones, la eficiencia de la comunicación de la red Xingmai aumentó en un 60%, la eficiencia del entrenamiento de modelos grandes aumentó en un 20% y también se mejoró la precisión de la localización de fallas. Estas mejoras ayudarán a mejorar la eficiencia y el rendimiento del entrenamiento de modelos grandes, permitiendo que los costosos recursos de GPU se utilicen más plenamente.

-

Es la época espeluznante del año, así que estos son algunos de los mejores juegos de terror que puedes jugar para darte un buen susto.

Es la época espeluznante del año, así que estos son algunos de los mejores juegos de terror que puedes jugar para darte un buen susto. -

Tutorial de escape de la sala de la casa de la luna

¡Resuelve el rompecabezas del apartamento de la casa de la luna! -

Cómo jugar Dice in Kingdom Come Deliverance 2: Todas las insignias y combos de puntuación

Si te estás preguntando cómo jugar dados en Kingdom Come: Deliverance 2, esto es lo que necesitas saber sobre eso. -

Cómo hacer un auto en construir un automóvil para matar zombis

¡Zombie Stampede!