Tencent Cloud lance Xingmai Network 2.0 pour accélérer la formation de grands modèles de 20 % supplémentaires

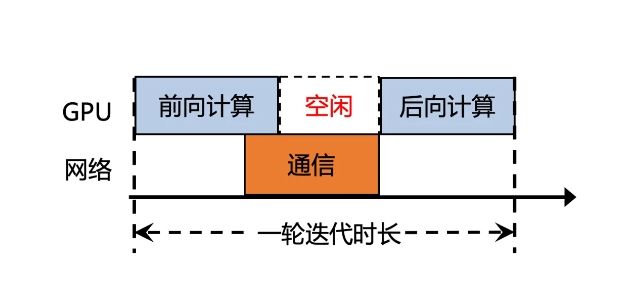

Tencent Cloud a récemment lancé une version améliorée de Xingmai Network 2.0, visant à améliorer l'efficacité de la formation de grands modèles. Dans la version précédente, le temps de communication de synchronisation des résultats de calcul des grands modèles représentait plus de 50 %, ce qui entraînait une faible efficacité. La nouvelle version de Xingmai Network 2.0 a été mise à niveau sous de nombreux aspects :

1. Prend en charge la mise en réseau de 100 000 cartes dans un seul cluster, doublant l'échelle, augmentant l'efficacité de la communication réseau de 60 %, augmentant l'efficacité de la formation des grands modèles de 20 % et réduisant la localisation des défauts de quelques jours à quelques minutes.

2. Les commutateurs, modules optiques, cartes réseau et autres équipements réseau auto-développés sont mis à niveau pour rendre l'infrastructure plus fiable et prendre en charge un seul cluster avec une échelle de plus de 100 000 cartes GPU.

3. Le nouveau protocole de communication TiTa2.0 est déployé sur la carte réseau et l'algorithme de congestion est mis à niveau vers un algorithme de contrôle de congestion actif. L'efficacité de la communication est augmentée de 30 % et l'efficacité de la formation des grands modèles est augmentée de 10 %.

4. La bibliothèque de communication collective haute performance TCCL2.0 utilise la communication parallèle hétérogène NVLINK+NET pour réaliser une transmission parallèle des données. Elle dispose également de l'algorithme adaptatif Auto-Tune Network Expert, qui améliore les performances de communication de 30 % et l'efficacité de la formation des grands modèles. 10 %.

5. La nouvelle plate-forme de simulation Lingjing à technologie exclusive Tencent peut surveiller entièrement le réseau de cluster, localiser avec précision les problèmes de nœuds GPU et réduire le temps de localisation des défauts de formation de niveau 10 000 ka de quelques jours à quelques minutes.

Grâce à ces mises à niveau, l'efficacité de la communication du réseau Xingmai a été augmentée de 60 %, l'efficacité de la formation des grands modèles a été augmentée de 20 % et la précision de la localisation des défauts a également été améliorée. Ces améliorations contribueront à améliorer l’efficacité et les performances de la formation de grands modèles, permettant ainsi d’utiliser plus pleinement les ressources GPU coûteuses.

-

C'est la période effrayante de l'année, alors voici quelques-uns des meilleurs jeux d'horreur auxquels vous pouvez jouer pour vous faire une bonne peur.

C'est la période effrayante de l'année, alors voici quelques-uns des meilleurs jeux d'horreur auxquels vous pouvez jouer pour vous faire une bonne peur. -

Moon House Room Escape Procédure pas à pas

Résolvez le puzzle de la visite de l'appartement de la maison Moon! -

Comment jouer des dés dans Kingdom Come Deliverance 2: Tous les badges et les combos de notation

Si vous vous demandez comment jouer des dés dans Kingdom Come: Deliverance 2, voici ce que vous devez savoir à ce sujet. -