Почему LLM всегда теряет рассудок в математике? Гуру искусственного интеллекта Карпати объясняет 9,9<9,11

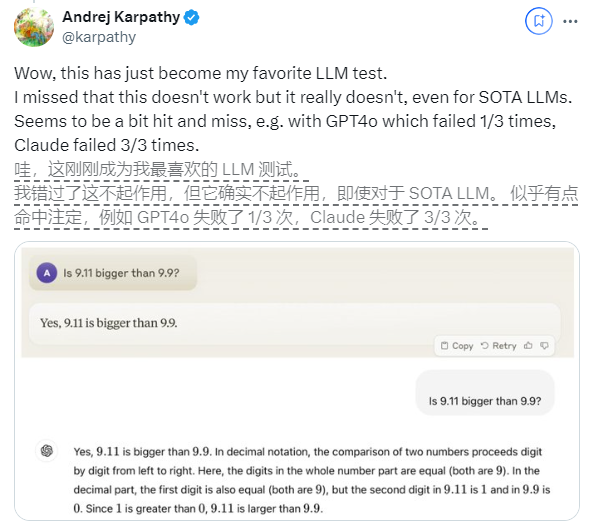

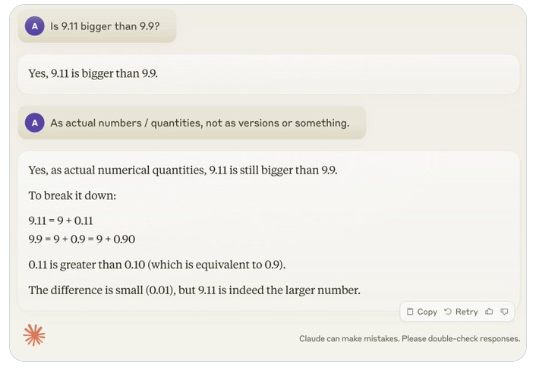

В последнее время, казалось бы, простой вопрос «9.11 больше, чем 9.9?» привлек широкое внимание во всем мире. Почти все большие языковые модели (LLM) допустили ошибки по этому вопросу. Это явление привлекло внимание Андрея Карпати, эксперта в области искусственного интеллекта. Начиная с этого вопроса, он глубоко обсудил существенные недостатки и направления дальнейшего совершенствования современной технологии больших моделей.

Карпати называет это явление «зубчатым интеллектом» или «зубчатым интеллектом», указывая на то, что, хотя современные LLM могут выполнять множество сложных задач, таких как решение сложных математических задач, они терпят неудачу в некоторых, казалось бы, простых задачах. плохо справляется с задачами, и этот дисбаланс интеллекта похож на форму пилы.

Например, исследователь OpenAI Ноам Браун обнаружил, что LLM плохо работает в игре «Крестики-нолики»: модель не может принимать правильные решения, даже когда пользователь был близок к победе. Карпати считает, что это происходит потому, что модель принимает «неоправданные» решения, в то время как Ноам считает, что это может быть связано с отсутствием соответствующего обсуждения стратегий в обучающих данных.

Другой пример — ошибка, которую допускает LLM при подсчете буквенно-цифровых величин. Даже последняя версия Llama 3.1 дает неправильные ответы на простые вопросы. Карпати объяснил, что это связано с отсутствием у LLM «самопознания», то есть модель не может отличить, что она может, а что не может делать, в результате чего модель «уверенно уверена» при решении задач.

Чтобы решить эту проблему, Карпати упомянул решение, предложенное в статье Llama3.1, опубликованной Meta. В документе рекомендуется добиться согласования модели на этапе после обучения, что позволит ей развить самосознание и узнать то, что она знает. Проблему иллюзий нельзя устранить, просто добавив фактические знания. Команда Llama предложила метод обучения под названием «обнаружение знаний», который побуждает модель отвечать только на те вопросы, которые она понимает, и отказывается давать неопределенные ответы.

Карпати считает, что, хотя существуют различные проблемы с нынешними возможностями ИИ, они не являются фундаментальными недостатками и существуют реальные решения. Он предположил, что текущая идея обучения ИИ заключается в том, чтобы просто «имитировать человеческие ярлыки и расширить масштабы». Чтобы продолжать совершенствовать интеллект ИИ, необходимо проделать дополнительную работу на протяжении всего процесса разработки.

Пока проблема не будет полностью решена, если LLM будут использоваться в производстве, им следует ограничиваться задачами, с которыми они хорошо справляются, учитывать «неровности» и постоянно привлекать людей. Таким образом, мы сможем лучше использовать потенциал ИИ, избегая при этом рисков, вызванных его ограничениями.

-

Это жуткое время года, так что вот некоторые из лучших игр ужасов, которые вы можете сыграть, чтобы дать себе хороший страх.

Это жуткое время года, так что вот некоторые из лучших игр ужасов, которые вы можете сыграть, чтобы дать себе хороший страх. -

Луна -хаус комната побег прохождение

Решите головоломку для жилых домов Moon House! -

Как играть в кубики в Королевстве.

Если вам интересно, как играть в кости в Королевстве: Освобождение 2, вот что вам нужно знать об этом. -

Как приготовить машину в строительстве машины, чтобы убить зомби

Zombie Stampede!