¿Por qué LLM siempre pierde la cabeza en matemáticas? El gurú de la IA Karpathy explica 9.9<9.11

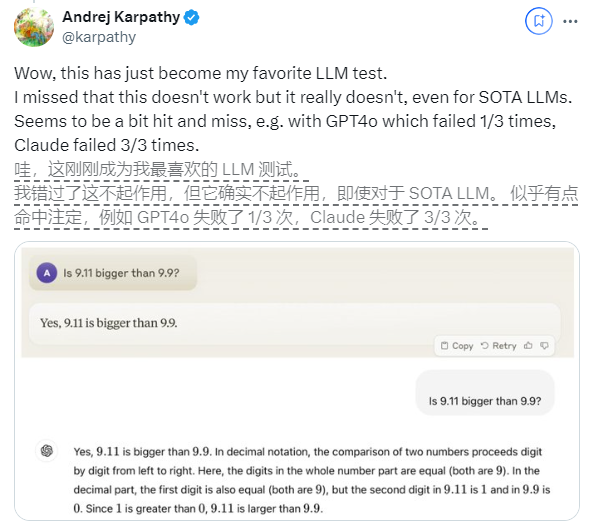

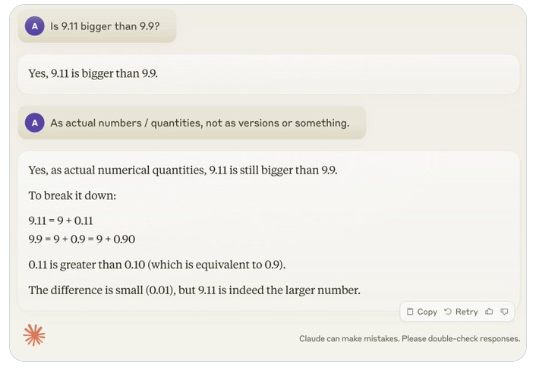

Recientemente, una pregunta aparentemente simple: "¿9.11 es mayor que 9.9?" ha atraído una atención generalizada en todo el mundo. Casi todos los modelos de lenguajes grandes (LLM) han cometido errores en este tema. Este fenómeno atrajo la atención de Andrej Karpathy, un experto en el campo de la IA. A partir de este tema, analizó en profundidad los defectos esenciales y las futuras direcciones de mejora de la tecnología actual de modelos grandes.

Karpathy llama a este fenómeno "inteligencia irregular" o "inteligencia irregular", y señala que, aunque los LLM de última generación pueden realizar una variedad de tareas complejas, como resolver problemas matemáticos difíciles, fallan en algunas tareas aparentemente simples. se desempeña mal en los problemas y este desequilibrio de inteligencia es similar a la forma de un diente de sierra.

Por ejemplo, el investigador de OpenAI, Noam Brown, descubrió que LLM tuvo un mal desempeño en el juego Tic-Tac-Toe, y el modelo era incapaz de tomar decisiones correctas incluso cuando el usuario estaba a punto de ganar. Karpathy cree que esto se debe a que el modelo toma decisiones "injustificadas", mientras que Noam cree que esto puede deberse a una falta de discusión relevante sobre estrategias en los datos de entrenamiento.

Otro ejemplo es el error que comete LLM al contar cantidades alfanuméricas. Incluso la última versión de Llama 3.1 da respuestas incorrectas a preguntas sencillas. Karpathy explicó que esto se debe a la falta de "autoconocimiento" de LLM, es decir, el modelo no puede distinguir lo que puede y lo que no puede hacer, lo que hace que el modelo se sienta "confiado" al enfrentar las tareas.

Para resolver este problema, Karpathy mencionó la solución propuesta en el artículo Llama3.1 publicado por Meta. El artículo recomienda lograr la alineación del modelo en la etapa posterior al entrenamiento, permitiendo que el modelo desarrolle autoconciencia y sepa lo que sabe. El problema de la ilusión no se puede erradicar simplemente agregando conocimiento fáctico. El equipo de Llama propuso un método de entrenamiento llamado "detección de conocimiento", que alienta al modelo a responder solo preguntas que comprende y se niega a generar respuestas inciertas.

Karpathy cree que aunque existen varios problemas con las capacidades actuales de la IA, estos no constituyen fallas fundamentales y existen soluciones factibles. Propuso que la idea actual del entrenamiento de IA es simplemente "imitar las etiquetas humanas y expandir la escala". Para continuar mejorando la inteligencia de la IA, es necesario trabajar más en todo el conjunto de desarrollo.

Hasta que el problema se resuelva por completo, si los LLM se van a utilizar en producción, deben limitarse a las tareas en las que son buenos, ser conscientes de los "bordes irregulares" y mantener a los humanos involucrados en todo momento. De esta manera, podremos explotar mejor el potencial de la IA evitando los riesgos causados por sus limitaciones.

-

Es la época espeluznante del año, así que estos son algunos de los mejores juegos de terror que puedes jugar para darte un buen susto.

Es la época espeluznante del año, así que estos son algunos de los mejores juegos de terror que puedes jugar para darte un buen susto. -

Tutorial de escape de la sala de la casa de la luna

¡Resuelve el rompecabezas del apartamento de la casa de la luna! -

Cómo jugar Dice in Kingdom Come Deliverance 2: Todas las insignias y combos de puntuación

Si te estás preguntando cómo jugar dados en Kingdom Come: Deliverance 2, esto es lo que necesitas saber sobre eso. -

Cómo hacer un auto en construir un automóvil para matar zombis

¡Zombie Stampede!