Modèles open source de la série Qwen2.5 d'Alibaba Tongyi Qianwen : Qwen2-VL-72B est comparable à GPT-4

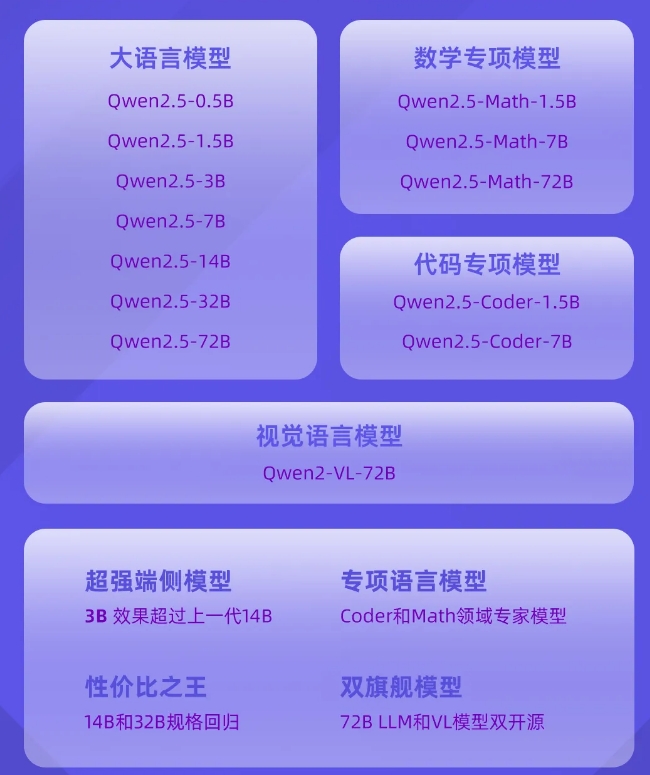

L'équipe Tongyi Qianwen a annoncé que trois mois après la sortie de Qwen2, le dernier membre de la famille Qwen, la série de modèles linguistiques Qwen2.5, est officiellement open source. Il s'agit peut-être de l'une des plus grandes versions open source de l'histoire, comprenant le modèle de langage général Qwen2.5, ainsi que les modèles Qwen2.5-Coder et Qwen2.5-Math spécifiquement destinés aux domaines de la programmation et des mathématiques.

Les modèles de la série Qwen2.5 sont pré-entraînés sur le dernier ensemble de données à grande échelle, qui contient jusqu'à 18 T de jetons. Par rapport à Qwen2, le nouveau modèle s'est considérablement amélioré en termes d'acquisition de connaissances, de capacité de programmation et de capacité mathématique. Le modèle prend en charge le traitement de texte long, peut générer du contenu jusqu'à 8 000 jetons et prend en charge plus de 29 langues.

Les modèles open source de la série Qwen2.5 adoptent non seulement la licence Apache2.0, mais fournissent également une variété de versions de différentes tailles pour s'adapter aux différents besoins des applications. De plus, l'équipe Tongyi Qianwen a également open source le modèle Qwen2-VL-72B avec des performances comparables à celles du GPT-4.

Le nouveau modèle apporte des améliorations significatives dans l'exécution des instructions, la génération de textes longs, la compréhension des données structurées et la génération de sorties structurées. En particulier dans les domaines de la programmation et des mathématiques, les modèles Qwen2.5-Coder et Qwen2.5-Math ont été formés sur des ensembles de données professionnelles, démontrant ainsi de plus fortes capacités dans les domaines professionnels.

Expérience du modèle de la série Qwen2.5 :

Collection Qwen2.5 : https://modelscope.cn/studios/qwen/Qwen2.5

-

C'est la période effrayante de l'année, alors voici quelques-uns des meilleurs jeux d'horreur auxquels vous pouvez jouer pour vous faire une bonne peur.

C'est la période effrayante de l'année, alors voici quelques-uns des meilleurs jeux d'horreur auxquels vous pouvez jouer pour vous faire une bonne peur. -

Moon House Room Escape Procédure pas à pas

Résolvez le puzzle de la visite de l'appartement de la maison Moon! -

Comment jouer des dés dans Kingdom Come Deliverance 2: Tous les badges et les combos de notation

Si vous vous demandez comment jouer des dés dans Kingdom Come: Deliverance 2, voici ce que vous devez savoir à ce sujet. -