AI 프로그래밍 능력이 진화한다! 대형 모델의 지속적인 PUA를 통해 코드 품질 향상 가능 - AI 기사

최근 몇 년 동안 인공지능(AI) 프로그래밍 능력은 계속해서 발전해 왔지만 아직 완벽에 이르지는 못했습니다. 최근 BuzzFeed의 수석 데이터 과학자인 Max Woolf는 실험을 통해 LLM(대형 언어 모델)에 "더 나은 코드 작성"이라는 메시지가 지속적으로 제공되면 AI가 실제로 더 나은 코드를 생성할 수 있다는 사실을 발견했습니다. 이번 발견은 폭넓은 관심을 끌었으며, 업계 내 유명 AI 과학자들도 큰 관심을 표하며 반복과 신속한 단어 디자인의 중요성을 강조했습니다.

Woolf의 실험에서 그는 AI 모델의 Claude3.5Sonnet 버전을 사용하여 일련의 프로그래밍 작업을 수행했습니다. 처음에 그는 숫자의 합이 30인 백만 개의 무작위 정수 중에서 최소값과 최대값의 차이를 찾는 방법이라는 간단한 프로그래밍 문제를 모델에 제시했습니다. 이 작업을 받은 후 Claude는 요구 사항을 충족하는 코드를 생성했지만 Woolf는 코드에 아직 최적화할 여지가 있다고 믿었습니다.

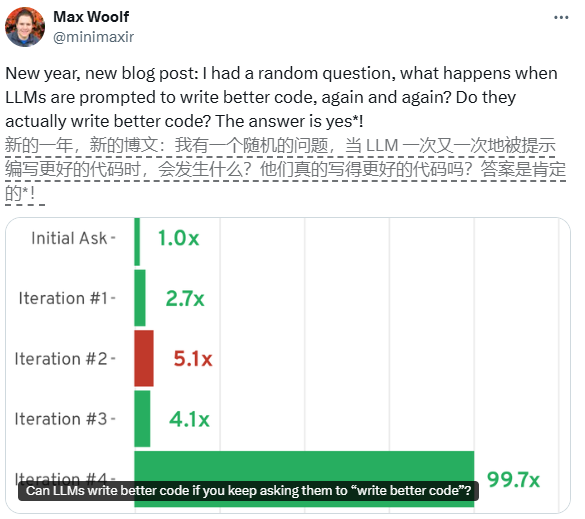

그러다가 Woolf는 코드를 생성한 후 매번 "더 나은 코드를 작성하세요"라는 프롬프트를 통해 Claude에게 반복적인 최적화를 수행하도록 요청하기로 결정했습니다. 첫 번째 반복 후 Claude는 코드를 객체 지향 Python 클래스로 리팩터링하고 두 가지 중요한 최적화를 구현하여 실행 속도를 2.7배 높였습니다. 두 번째 반복에서 Claude는 멀티스레딩 처리와 벡터화된 계산을 추가하여 궁극적으로 기본 버전보다 코드 실행 속도가 5.1배 빨라졌습니다.

그러나 반복 횟수가 증가함에 따라 코드 품질 개선 속도가 느려지기 시작합니다. 여러 차례의 최적화 후에 모델은 JIT 컴파일 및 비동기 프로그래밍과 같은 좀 더 정교한 기술을 사용하려고 시도했지만 일부 반복에서는 성능 저하가 발생했습니다. 궁극적으로 Woolf의 실험은 반복 프롬프트의 잠재력과 한계를 밝혀 사람들에게 AI 프로그래밍의 미래에 대한 새로운 생각을 제공했습니다.

이 연구는 프로그래밍 분야에서 AI의 응용 가능성을 보여줄 뿐만 아니라 AI가 지속적인 반복을 통해 코드 품질을 향상시킬 수 있지만 실제 응용에서는 프롬프트 단어를 적절하게 디자인하고 성능과 복잡성의 균형을 맞추는 방법이 여전히 가치가 있음을 상기시켜 줍니다. 문제를 심도있게 논의했습니다.

-

올해의 으스스한 시간이므로 여기에 자신에게 좋은 공포를주기 위해 플레이 할 수있는 최고의 공포 게임이 있습니다.

올해의 으스스한 시간이므로 여기에 자신에게 좋은 공포를주기 위해 플레이 할 수있는 최고의 공포 게임이 있습니다. -

문 하우스 룸 탈출 연습

Moon House Apartment Tour Puzzle을 해결하십시오! -

왕국에서 주사위를 연주하는 법 2 : 모든 배지 및 득점 콤보

왕국에서 주사위를 연주하는 방법이 궁금하다면 : Deliverance 2, 여기에 대해 알아야 할 사항은 다음과 같습니다. -

좀비를 죽이기 위해 차를 짓는 차를 만드는 방법

좀비 스탬피드!