L'exploration fréquente par les robots d'exploration OpenAI provoque le crash du site Web de modèles 3D du corps humain - Article AI

Récemment, Trilegangers, un site Web ukrainien axé sur les modèles 3D du corps humain, a subi une attaque de trafic sans précédent, provoquant un crash de son serveur. Ce site Web est dédié à fournir aux artistes 3D et aux développeurs de jeux des données massives de modèles 3D humains. Cependant, il est en difficulté en raison de l'exploration fréquente du robot d'exploration GPTBot d'OpenAI.

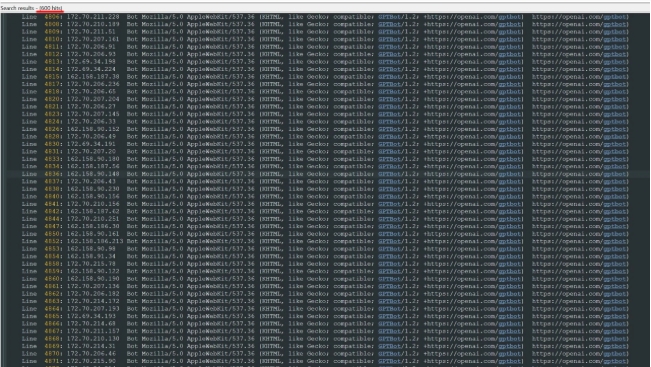

Selon le personnel de Trilegangers, bien que l'accord d'utilisation du site Web interdise clairement l'exploration et l'utilisation non autorisées, le fichier robots.txt n'a pas été correctement configuré pour empêcher l'accès des robots, ce qui a finalement conduit à une surcharge du serveur. Selon les journaux du serveur, le robot d'exploration GPTBot d'OpenAI a lancé des dizaines de milliers de requêtes via plus de 600 adresses IP différentes, ce qui a entraîné un dysfonctionnement du site Web, semblable à une attaque par déni de service distribué (DDoS).

OpenAI a mentionné dans la description de son robot d'exploration que si le site Web ne souhaite pas que GPTBot explore le contenu, il doit être défini dans le fichier robots.txt. Cependant, les Trilegangers ne s’en sont pas rendu compte, ce qui a conduit à leur situation difficile actuelle. Bien qu'un fichier robots.txt ne soit pas une obligation légale, si le site Web a déclaré que toute utilisation non autorisée est interdite, le comportement d'exploration de GPTBot peut toujours enfreindre les réglementations en vigueur.

De plus, en raison de l'utilisation des serveurs Amazon AWS, la consommation de bande passante et de trafic de Trilegangers a également fortement augmenté, ce qui entraîne une pression supplémentaire sur les coûts. En réponse à cette urgence, Trilegangers a pris des mesures pour configurer le fichier robots.txt correct et bloqué l'accès de divers robots d'exploration, dont GPTBot via Cloudflare. Cette approche devrait alléger efficacement la charge sur le serveur et protéger le site Web normalement. opération.

Cet incident a attiré l'attention sur le comportement des robots d'exploration du Web, en particulier dans le contexte du développement croissant de la technologie de l'IA. La manière de concilier les applications technologiques et la protection des droits d'auteur est devenue un sujet qui mérite réflexion.

-

C'est la période effrayante de l'année, alors voici quelques-uns des meilleurs jeux d'horreur auxquels vous pouvez jouer pour vous faire une bonne peur.

C'est la période effrayante de l'année, alors voici quelques-uns des meilleurs jeux d'horreur auxquels vous pouvez jouer pour vous faire une bonne peur. -

Moon House Room Escape Procédure pas à pas

Résolvez le puzzle de la visite de l'appartement de la maison Moon! -

Comment jouer des dés dans Kingdom Come Deliverance 2: Tous les badges et les combos de notation

Si vous vous demandez comment jouer des dés dans Kingdom Come: Deliverance 2, voici ce que vous devez savoir à ce sujet. -